OpenSearch на VDS — частый выбор для логирования, поиска и аналитики без тяжёлого кластера. Но даже на одном узле легко «поймать» OOM, долгие GC‑паузы, flood_stage из‑за диска или раздувшийся mapping. В этой статье — практический чек‑лист: как спланировать ресурсы VDS, выставить разумный JVM heap, включить Index State Management (ISM) с rollover и удалением, а также безболезненно настроить snapshots. Цель — стабильный нод, предсказуемая ретенция и восстановление за минуты.

Зачем OpenSearch на VDS и где границы

Одинокий узел на VDS хорош для небольших объёмов: десятки гигабайт индексов, сотни гигабайт при правильной ротации и SSD/NVMe. Вы выигрываете в простоте: меньше сетевых хвостов, минимальная задержка ввода‑вывода, прозрачная эксплуатация. Ограничения очевидны: нет автоматической отказоустойчивости и rolling‑обновлений без кратких пауз. Поэтому ключевое — заранее планировать объёмы данных, индексирование, ретенцию и резервные копии.

Планирование ресурсов VDS под OpenSearch

Сбалансируйте CPU, RAM и диск с учётом профиля нагрузки. Запись логов требует высокой скорости fsync и устойчивости к комитету транзакций; поиск по полям — памяти под кэш сегментов и фильтров; агрегации — CPU и IO.

- CPU: минимум 2 vCPU, комфортно 4–8 vCPU. Агрегации и массовые мержи сегментов хорошо распараллеливаются.

- RAM: стартуйте с 8–16 ГБ; для индексов 100–300 ГБ и активного поиска — 16–32 ГБ. Помните: не весь объём отдаётся

JVM heap, часть нужна ОС под page cache. - Диск: только SSD/NVMe. Цель — низкая латентность, высокий IOPS. Планируйте +30–50% от объёма данных под сегменты, мержи, транслоги и снапшоты на локальном репозитории (если используете файл‑репозиторий).

- Сеть: если снапшоты уводите во внешний объектный сторедж, учитывайте окно бэкапа и пропускную способность.

Если выбираете конфигурацию впервые, обратитесь к материалу как подобрать VDS по CPU и RAM под нагрузку — он поможет оценить запас по ресурсам.

ОС и лимиты: подготовка VDS

Прежде чем запускать OpenSearch, проверьте базовые настройки ОС, чтобы не упереться в потолки ядра и дескрипторов.

# Файловые дескрипторы (runtime)

ulimit -n 1048576

# Системные карты памяти под mmap

sudo sysctl -w vm.max_map_count=262144

# Погашаем агрессивный swap

sudo sysctl -w vm.swappiness=1

# В CentOS/RHEL/Ubuntu можно перевести Transparent Huge Pages в madvise

# (устойчивее для нагрузок Lucene/Java)

# Документация ОС подскажет команду для вашей версии.

Зафиксируйте лимиты на постоянной основе через файлы конфигурации системы и systemd‑override для сервиса OpenSearch:

# /etc/systemd/system/opensearch.service.d/override.conf

[Service]

LimitNOFILE=1048576

LimitMEMLOCK=infinity

И включите блокировку памяти в конфигурации OpenSearch, чтобы heap не вытеснялся в swap:

# /etc/opensearch/opensearch.yml

bootstrap.memory_lock: true

JVM heap: сколько и как настраивать

Общая рекомендация: heap ≈ 50% RAM хоста, но не более ~31 ГБ, чтобы сохранить сжатые указатели (CompressedOops) и эффективность GC. Оставшаяся память важна для page cache, где ОС кэширует сегменты Lucene — это критично для поиска и агрегаций.

- 8 ГБ RAM VDS: выставляйте 3–4 ГБ heap.

- 16 ГБ RAM: 6–8 ГБ heap.

- 32 ГБ RAM: 12–16 ГБ heap (редко больше, если вы активно кешируете fielddata/агрегации).

Фиксируйте одинаковые -Xms и -Xmx, чтобы JVM не расширяла кучу на лету и не вносила латентность:

# /etc/opensearch/jvm.options

-Xms8g

-Xmx8g

-XX:+AlwaysPreTouch

-XX:+UseG1GC

-XX:InitiatingHeapOccupancyPercent=30

-XX:MaxGCPauseMillis=200

Почему G1GC? Он хорошо держит паузы при больших heaps и перемешанных нагрузках запись/поиск. Для очень малых heaps альтернативы могут дать иной профиль латентности, но G1GC остаётся безопасным дефолтом для OpenSearch. -XX:+AlwaysPreTouch уменьшает сюрпризы от ленивого выделения памяти на долгоживущих процессах.

Файловая система и диски

Используйте ext4 или XFS с опциями, исключающими лишние записи метаданных (например, noatime). На VDS особенно важны предсказуемые задержки ввода-вывода. Из практики:

- Отдельный диск/том под данные OpenSearch сокращает конкуренцию за I/O.

- Запас свободного места держите не менее 20–30%: иначе столкнётесь с watermark‑порогами и throttling.

- Контролируйте write amplification — избегайте больших batch‑перепаковок в часы пик.

Базовая конфигурация OpenSearch

Минимальный набор для одного узла, ориентированный на стабильность:

# /etc/opensearch/opensearch.yml

cluster.name: vds-opensearch

node.name: vds-1

path.data: /var/lib/opensearch

path.logs: /var/log/opensearch

network.host: 0.0.0.0

http.port: 9200

# В проде обязательно включите TLS и аутентификацию security-плагина.

# На одном узле реплики не нужны, экономим место и время на мержи

index.number_of_replicas: 0

# Контроль дисковых порогов (пример с абсолютными значениями)

cluster.routing.allocation.disk.watermark.low: 75%

cluster.routing.allocation.disk.watermark.high: 85%

cluster.routing.allocation.disk.watermark.flood_stage: 95%

Если планируете позже масштабировать до 2–3 узлов, закладывайте index.number_of_shards и реплики в шаблоне индексов заранее. Для одиночного узла чаще всего достаточно 1–2 шардов на индекс.

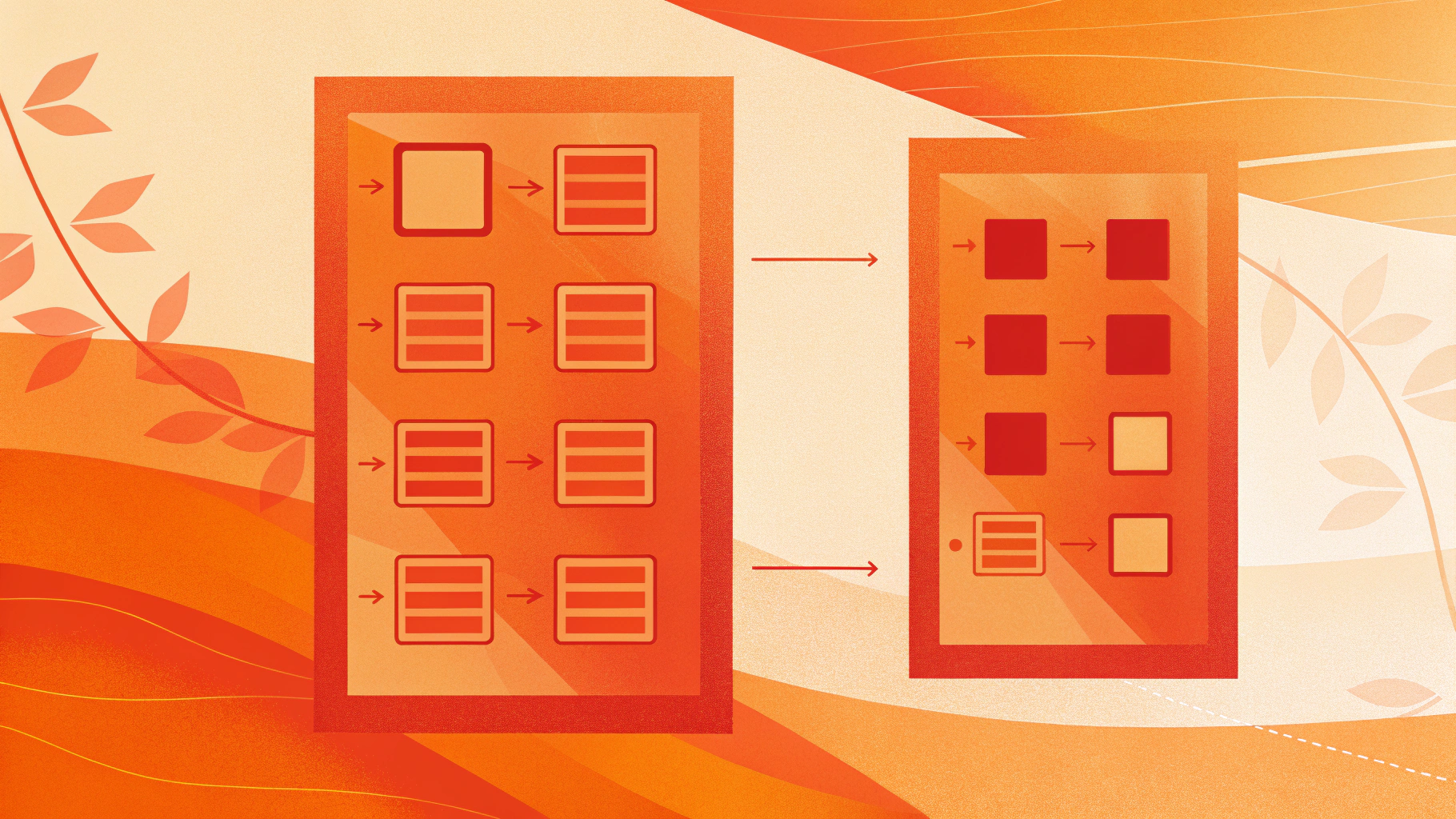

Index State Management (ISM): ротация, «тёплые» фазы и удаление

ISM — встроенный механизм жизненного цикла индексов: позволяет автоматизировать rollover, оптимизацию и удаление. Для VDS‑сценария с одним узлом фокус простой: своевременный rollover (чтобы шард не рос бесконечно), снапшот перед удалением и чистка, чтобы держать диск в зелёной зоне.

Пример ISM‑политики с rollover и удалением

Создадим политику: горячая фаза пишет в текущий индекс; при достижении пределов выполняется rollover, затем через заданный срок берётся снапшот и индекс удаляется.

PUT _plugins/_ism/policies/logs_hot_delete

{

"policy": {

"description": "Hot rollover, snapshot, delete",

"default_state": "hot",

"states": [

{

"name": "hot",

"actions": [

{

"rollover": {

"min_size": "30gb",

"min_index_age": "1d"

}

}

],

"transitions": [

{

"state_name": "retention",

"conditions": {

"min_index_age": "7d"

}

}

]

},

{

"name": "retention",

"actions": [

{

"snapshot": {

"repository": "fs_snapshots",

"snapshot": "snap_{index}_{now/d}"

}

},

{ "delete": {} }

],

"transitions": []

}

]

}

}

Смысловые акценты:

rolloverограничивает размер сегментов и ускоряет поиск: новые записи уходят в свежий индекс, старые перестают «расти» и меньше фрагментируются.snapshotперед удалением даёт возможность быстро восстановить исторические данные, не держа их на дорогом SSD VDS.- Ретенция по возрасту держит диск под контролем и предотвращает flood_stage.

Index template и alias для rollover

Rollover работает с alias: пишем в алиас, а сам индекс регулярно «перекатывается» на новый суффикс.

PUT _index_template/logs_template

{

"index_patterns": ["logs-*"],

"template": {

"settings": {

"index.number_of_shards": 1,

"index.number_of_replicas": 0,

"index.refresh_interval": "5s",

"plugins.index_state_management.policy_id": "logs_hot_delete"

},

"mappings": {

"dynamic": true

}

},

"priority": 100

}

# Создаём начальный индекс и алиас для записи

PUT logs-000001

{

"aliases": {

"logs-write": {

"is_write_index": true

}

}

}

Дальше ваш инжест отправляет документы в logs-write, а ISM сам выполняет rollover на logs-000002, logs-000003 и т. д. Управляйте критериями rollover по размеру и/или возрасту, чтобы индекс не разрастался до гигабайт на один шард без остановки.

Snapshots: репозиторий, расписание, проверка восстановления

Снапшоты — страховка от удаления и поломок. Даже на одном узле держите резервную копию вне «боевого» каталога данных. Удобно начинать с файлового репозитория на отдельном томе или примонтированном каталоге бэкапов.

# Регистрируем файловый репозиторий

PUT _snapshot/fs_snapshots

{

"type": "fs",

"settings": {

"location": "/var/backups/opensearch-snapshots",

"compress": true

}

}

# Ручной снапшот всех индексов

PUT _snapshot/fs_snapshots/manual-2025-01-15?wait_for_completion=true

Интегрируйте снапшоты с ISM (как в примере выше) или запускайте по расписанию через таймер ОС. Критически важно регулярно проверять восстановление (на отдельном стенде или временной папке данных): так вы узнаете реальное RTO и выявите проблемы с правами/доступом заранее.

Параметры индекса и схемы данных

Правильные настройки индекса снижают нагрузку на heap и диск:

- Mapping: фиксируйте типы полей, где возможно. Избегайте «взрывного» динамического маппинга по непредсказуемым ключам. Используйте

ignore_aboveи ограниченный набор анализаторов. - refresh_interval: для потоковой записи 1–5s достаточно. При массовой заливке временно поднимайте до 30–60s, затем возвращайте.

- replicas: на одиночном узле держите 0. Если добавите второй узел — переключитесь на 1.

- shards: меньше — лучше. Один шард до 30–50 ГБ на VDS с NVMe и умеренной конкуренцией — разумный компромисс.

Мониторинг: что смотреть ежедневно

Без внешних систем мониторинга всё равно можно держать руку на пульсе через API:

_cat/nodes?v: heap.percent, cpu, load, ram._nodes/stats/jvm,fs,indices: GC‑паузы, кеши, IO, скорость мерджей._cat/indices?v: размеры шардов и состояние индексов._cluster/health: быстрое самочувствие кластера.

Следите за heap.percent под пиками. Регулярные выходы за 85–90% с длинными GC‑пауза ми — повод уменьшить поле для агрегаций, пересмотреть маппинг или увеличить память VDS/heap. Аномально долгие мерджи и рост транслога — сигнал о нехватке I/O.

Обслуживание: очистка, форс‑мердж и рестарты

Ежедневные операции:

- Проверка свободного места и порогов watermark: держите запас ≥ 20%.

- Удаление старых индексов через ISM — без ручной рутины.

- Форс‑мердж только для «замороженных» индексов, по необходимости. На горячих — не злоупотребляйте, это I/O‑дорого.

- Рестарт по таймеру не обязателен. Лучше рестартовать по показаниям: утечки, обновления, смена heap. Планируйте окна в непиковое время.

Типичные проблемы и как их избежать

- OOM/Killed: слишком маленький heap или взрыв fielddata. Фикс: увеличить heap в разумных пределах, упорядочить маппинг, включить doc_values и избегать агрегаций по высококардинальным текстовым полям.

- flood_stage: кончился диск. Фикс: ротация через ISM, повышение ёмкости, перенос части индексов в снапшоты.

- Долгие GC‑паузы: большой heap и активные агрегации. Фикс: тюнинг G1GC, уменьшение heap при достаточном page cache, пересмотр запросов и полей.

- Медленный индексинг: повышенный

refresh_intervalулучшит throughput, но увеличит задержку видимости документов. Балансируйте под задачу. - Медленный поиск: пересмотрите шардирование (слишком много мелких шардов), убедитесь, что горячие индексы не раздуваются сверх лимитов rollover.

Безопасность и сетевой периметр

Не публикуйте OpenSearch напрямую в интернет. Используйте брандмауэр и прокси. Включите security‑плагин, заведите пользователей с минимально необходимыми правами. Для API используйте отдельные роли на запись/чтение. TLS обязателен в проде — как на HTTP, так и на транспорте, если узлов несколько. Для продакшена используйте SSL-сертификаты.

Повысить изоляцию процесса поможет hardening systemd‑юнита: применяйте ограничения прав и пространства имён, подробнее в статье жёсткая изоляция сервисов в systemd на VDS.

Чек‑лист внедрения на VDS

Работайте от простого к надёжному: сначала стабилизируйте ОС и heap, затем внедряйте ISM и снапшоты, и только после этого оптимизируйте детали маппинга и агрегаций.

- Подберите VDS с запасом RAM/IO и отдельным SSD/NVMe.

- Настройте лимиты:

vm.max_map_count, дескрипторы,memory_lock. - Выставьте

-Xms/-Xmxодинаково, начните с 50% RAM (но не более ~31 ГБ). - Определите шардирование: 1 шард, 0 реплик на одном узле.

- Создайте ISM‑политику: rollover по размеру и возрасту, снапшот, удаление.

- Заведите файловый репозиторий снапшотов и регулярно проверяйте восстановление.

- Включите мониторинг через

_catи_nodes/stats, заведите оповещения. - Не публикуйте без защиты; разграничьте доступы и включите TLS.

Когда масштабироваться

Признаки, что одному узлу тесно: постоянный heap > 85%, рост 99‑перцентиля задержек поиска, регулярные выходы на watermark‑пороги и ночные мерджи, забирающие часы. Тогда добавляйте второй узел, включайте реплики, переносите часть индексов в «тёплые» диски или в отдельный узел для холодных данных. Но до этого момента грамотный jvm heap, ISM и дисциплина снапшотов позволяют очень далеко уехать даже на одном VDS.

Итог: у вас есть понятный путь — подготовка ОС, аккуратный heap, политика ISM с rollover и удалением, регулярные snapshots и здравый мониторинг. Эти шаги дают ровную производительность, предсказуемые затраты и спокойный сон дежурного админа.